La inteligencia artificial (IA) está creciendo rápidamente, pero sus enormes demandas de energía y costos computacionales se están volviendo insostenibles. Ahora, está surgiendo una solución sorprendente del mundo de la física cuántica: las redes tensoriales. Estas estructuras matemáticas, originalmente desarrolladas para manejar interacciones complejas entre partículas, están demostrando ser notablemente efectivas para comprimir modelos de IA, reducir el consumo de energía e incluso hacer que la IA sea más accesible.

El cuello de botella: modelos de IA inflados

Los modelos de lenguajes grandes (LLM, por sus siglas en inglés) como ChatGPT consumen notoriamente muchos recursos. Su tamaño y complejidad requieren grandes cantidades de energía para entrenarse y funcionar, lo que lleva a algunas empresas de tecnología a considerar soluciones extremas, como pequeñas plantas de energía nuclear dedicadas para mantener los centros de datos en línea. Esta no es sólo una preocupación ambiental; también limita dónde se puede implementar la IA.

El problema central es la dimensionalidad. A medida que los modelos de IA abordan tareas más complejas, la cantidad de variables se dispara, lo que hace imposible el almacenamiento y el procesamiento. Los físicos resolvieron esto hace décadas con redes tensoriales.

Redes tensoriales: una solución de compresión basada en la física

Las redes tensoriales dividen conjuntos de datos colosales en componentes más pequeños y manejables. Imagine una salchicha gigante que es demasiado grande para cocinarla de una vez; torcerlo en porciones perfectas para hot dogs lo deja listo para asar. De manera similar, las redes tensoriales diseccionan tensores masivos (matrices multidimensionales de números) en tensores más pequeños vinculados.

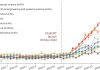

¿La ventaja clave? Conservan la precisión y reducen significativamente el tamaño. Multiverse Computing, una startup cofundada por el físico Román Orús, ya lo ha demostrado con el modelo Llama 2 7B. Su técnica CompactifAI comprime el modelo en más del 90%, de 27 GB a solo 2 GB, con una caída mínima en la precisión.

Más allá de la compresión: una nueva arquitectura de IA

La visión a largo plazo es aún más audaz: construir modelos de IA desde cero utilizando redes tensoriales, evitando por completo las redes neuronales tradicionales. Las redes neuronales, si bien son poderosas, consumen mucha energía y son opacas. Las redes tensoriales ofrecen el potencial para un entrenamiento más rápido y un funcionamiento interno más transparente.

Miles Stoudenmire, del Flatiron Institute, cree que este enfoque podría desbloquear el “poder latente” de la IA, permitiéndole funcionar de manera eficiente en dispositivos personales sin depender de conexiones en la nube. Imagínese refrigeradores o lavadoras con tecnología de inteligencia artificial funcionando sin conexión.

Cómo funciona: la maldición de la dimensionalidad y su cura

La “maldición de la dimensionalidad” es la idea de que a medida que aumenta la complejidad de los datos, el almacenamiento se vuelve imposible. Una hoja de cálculo es una matriz 2D; Los tensores generalizan esto a múltiples dimensiones. Considere realizar un seguimiento de las preferencias de pizza de 100 000 personas (100 aderezos, 100 salsas). El tensor resultante tendría mil millones de números, pero aún sería manejable. Sin embargo, agregue más variables (corteza, queso) y el tamaño aumentará exponencialmente.

Las redes tensoriales resuelven esto representando un tensor gigante como una red de otros más pequeños. Las correlaciones entre puntos de datos son clave. Por ejemplo, a las personas a las que les gustan los champiñones blancos también les gustan los cremini. Al eliminar la redundancia, las redes tensoriales comprimen el modelo sin sacrificar el rendimiento.

Resultados del mundo real y perspectivas futuras

Los beneficios ya se están viendo en la práctica. Sopra Steria descubrió que la versión comprimida de Llama 3.1 8B de Multiverse utilizaba entre un 30% y un 40% menos de energía. Investigadores del Imperial College de Londres han demostrado que la compresión de redes tensoriales puede incluso mejorar la precisión en comparación con los modelos de tamaño completo, ya que los grandes conjuntos de datos a menudo contienen irrelevancias filtradas por la técnica.

El objetivo final es ir más allá de la compresión y crear arquitecturas de IA completamente nuevas basadas en redes tensoriales. Este enfoque podría reducir drásticamente los tiempos de entrenamiento (un modelo entrenado en demostración en 4 segundos en comparación con los 6 minutos de una contraparte de red neuronal) y hacer que los modelos de IA sean más comprensibles.

Las redes tensoriales no son sólo un truco de compresión; representan un cambio fundamental en la forma en que construimos e implementamos la IA. Si tiene éxito, esto podría desbloquear un futuro en el que la IA poderosa sea energéticamente eficiente, accesible y transparente.