L’intelligenza artificiale (AI) sta crescendo rapidamente, ma le sue enormi richieste di energia e i costi computazionali stanno diventando insostenibili. Ora, una soluzione sorprendente sta emergendo dal mondo della fisica quantistica: le reti tensoriali. Sviluppate originariamente per gestire interazioni complesse tra particelle, queste strutture matematiche si stanno rivelando straordinariamente efficaci nel comprimere i modelli di intelligenza artificiale, ridurre il consumo di energia e persino rendere l’intelligenza artificiale più accessibile.

Il collo di bottiglia: modelli di intelligenza artificiale gonfiati

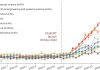

I modelli linguistici di grandi dimensioni (LLM) come ChatGPT sono notoriamente dispendiosi in termini di risorse. Le loro dimensioni e complessità richiedono grandi quantità di energia per l’addestramento e il funzionamento, spingendo alcune aziende tecnologiche a prendere in considerazione soluzioni estreme come piccole centrali nucleari dedicate per mantenere online i data center. Questa non è solo una preoccupazione ambientale; limita anche il luogo in cui l’intelligenza artificiale può essere implementata.

Il problema centrale è la dimensionalità. Man mano che i modelli di intelligenza artificiale affrontano compiti più complessi, il numero di variabili esplode, rendendo impossibile l’archiviazione e l’elaborazione. I fisici hanno risolto questo problema decenni fa con le reti tensoriali.

Reti tensoriali: una soluzione di compressione basata sulla fisica

Le reti tensoriali scompongono set di dati colossali in componenti più piccoli e più gestibili. Immagina una salsiccia gigante troppo grande per essere cucinata tutta in una volta; trasformandolo in hot dog perfettamente porzionati lo rende pronto per la griglia. Allo stesso modo, le reti tensoriali sezionano tensori massicci (array multidimensionali di numeri) in tensori collegati e più piccoli.

Il vantaggio principale? Preservano la precisione riducendo significativamente le dimensioni. Multiverse Computing, una startup co-fondata dal fisico Román Orús, lo ha già dimostrato con il modello Llama 2 7B. La loro tecnica CompactifAI comprime il modello di oltre il 90%, da 27 GB a soli 2 GB, con un calo minimo di precisione.

Oltre la compressione: una nuova architettura AI

La visione a lungo termine è ancora più audace: costruire modelli di intelligenza artificiale da zero utilizzando reti tensoriali, aggirando completamente le reti neurali tradizionali. Le reti neurali, sebbene potenti, sono assetate di energia e opache. Le reti tensoriali offrono il potenziale per un addestramento più rapido e un funzionamento interno più trasparente.

Miles Stoudenmire del Flatiron Institute ritiene che questo approccio potrebbe sbloccare il “potere latente” dell’intelligenza artificiale, consentendole di funzionare in modo efficiente sui dispositivi personali senza fare affidamento sulle connessioni cloud. Immagina frigoriferi o lavatrici alimentati dall’intelligenza artificiale che funzionano offline.

Come funziona: la maledizione della dimensionalità e la sua cura

La “maledizione della dimensionalità” è l’idea che con l’aumento della complessità dei dati, l’archiviazione diventa impossibile. Un foglio di calcolo è una matrice 2D; i tensori generalizzano questo a più dimensioni. Considera il monitoraggio delle preferenze sulla pizza di 100.000 persone (100 condimenti, 100 salse). Il tensore risultante avrebbe un miliardo di numeri, ma sarebbe comunque gestibile. Tuttavia, aggiungi più variabili (crosta, formaggio) e le dimensioni dei palloncini in modo esponenziale.

Le reti tensoriali risolvono questo problema rappresentando un tensore gigante come una rete di tensori più piccoli. Le correlazioni tra i punti dati sono fondamentali. Ad esempio, alle persone a cui piacciono i funghi bianchi piacciono anche i cremini. Eliminando la ridondanza, le reti tensoriali comprimono il modello senza sacrificare le prestazioni.

Risultati reali e prospettive future

I vantaggi sono già visibili nella pratica. Sopra Steria ha scoperto che la versione compressa di Llama 3.1 8B di Multiverse utilizzava il 30-40% di energia in meno. I ricercatori dell’Imperial College di Londra hanno dimostrato che la compressione della rete tensore può persino migliorare la precisione rispetto ai modelli a grandezza naturale, poiché i set di dati di grandi dimensioni spesso contengono irrilevanze filtrate dalla tecnica.

L’obiettivo finale è andare oltre la compressione e creare architetture IA completamente nuove basate su reti tensoriali. Questo approccio potrebbe ridurre drasticamente i tempi di addestramento (un modello demo addestrato in 4 secondi rispetto ai 6 minuti per una controparte di rete neurale) e rendere i modelli IA più comprensibili.

Le reti tensoriali non sono solo un trucco di compressione; rappresentano un cambiamento fondamentale nel modo in cui costruiamo e distribuiamo l’intelligenza artificiale. In caso di successo, ciò potrebbe sbloccare un futuro in cui la potente intelligenza artificiale sarà efficiente dal punto di vista energetico, accessibile e trasparente.