Искусственный интеллект (ИИ) развивается стремительно, но его колоссальные энергетические потребности и вычислительные затраты становятся неустойчивыми. Теперь неожиданное решение появляется из мира квантовой физики: тензорные сети. Изначально разработанные для обработки сложных взаимодействий между частицами, эти математические структуры оказываются удивительно эффективными для сжатия моделей ИИ, снижения энергопотребления и даже повышения доступности ИИ.

Узкое место: Раздутые модели ИИ

Большие языковые модели (LLM), такие как ChatGPT, печально известны своей ресурсоёмкостью. Их размер и сложность требуют огромного количества энергии для обучения и работы, что заставляет некоторые технологические компании рассматривать экстремальные решения, такие как выделенные мини-ядерные электростанции для поддержания работы центров обработки данных. Это не только экологическая проблема; она также ограничивает области применения ИИ.

Основная проблема — размерность. По мере того как модели ИИ решают более сложные задачи, количество переменных взрывообразно растёт, что делает хранение и обработку невозможными. Физики решили эту проблему десятилетия назад с помощью тензорных сетей.

Тензорные сети: Решение сжатия на основе физики

Тензорные сети разбивают огромные наборы данных на более мелкие, управляемые компоненты. Представьте себе гигантскую колбасу, которую слишком велика, чтобы приготовить сразу; если её скрутить в идеально порционные хот-доги, её будет легко жарить. Аналогично, тензорные сети разбирают массивные тензоры (многомерные массивы чисел) на связанные, меньшие тензоры.

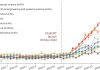

Ключевое преимущество? Они сохраняют точность при значительном уменьшении размера. Multiverse Computing, стартап, основанный физиком Романом Орусом, уже продемонстрировал это на модели Llama 2 7B. Их техника CompactifAI сжимает модель более чем на 90%, с 27 ГБ до всего 2 ГБ, с минимальной потерей точности.

За пределами сжатия: Новая архитектура ИИ

Долгосрочное видение ещё смелее: создание моделей ИИ с нуля с использованием тензорных сетей, обходя традиционные нейронные сети. Нейронные сети, хотя и мощные, являются энергоёмкими и непрозрачными. Тензорные сети предлагают потенциал для более быстрого обучения и более прозрачной внутренней работы.

Майлс Стауденмайр из Института Флэтэрон считает, что этот подход может раскрыть «скрытую мощь» в ИИ, позволяя ему эффективно работать на личных устройствах без подключения к облаку. Представьте себе холодильники или стиральные машины с поддержкой ИИ, работающие в автономном режиме.

Как это работает: Проклятие размерности и его лекарство

«Проклятие размерности» — это идея о том, что по мере роста сложности данных хранение становится невозможным. Таблица — это 2D-матрица; тензоры обобщают это до нескольких измерений. Рассмотрим отслеживание предпочтений в пицце для 100 000 человек (100 начинок, 100 соусов). Получающийся тензор будет содержать один миллиард чисел, но всё ещё управляемый. Однако добавьте больше переменных (корка, сыр), и размер вырастет экспоненциально.

Тензорные сети решают эту проблему, представляя гигантский тензор как сеть меньших. Ключевыми являются корреляции между точками данных. Например, люди, которые любят белые грибы, также любят кремини. Устраняя избыточность, тензорные сети сжимают модель, не жертвуя производительностью.

Реальные результаты и будущие перспективы

Преимущества уже видны на практике. Sopra Steria обнаружила, что сжатая версия Multiverse Llama 3.1 8B использует на 30–40% меньше энергии. Исследователи из Имперского колледжа Лондона показали, что сжатие с помощью тензорных сетей даже может улучшить точность по сравнению с полноразмерными моделями, поскольку большие наборы данных часто содержат нерелевантности, которые удаляются с помощью этой техники.

Конечная цель — отойти от сжатия и создать совершенно новые архитектуры ИИ на основе тензорных сетей. Этот подход может резко сократить время обучения (одна из продемонстрированных моделей обучилась за 4 секунды по сравнению с 6 минутами для аналога на нейронной сети) и сделать модели ИИ более понятными.

Тензорные сети — это не просто трюк с сжатием; они представляют собой фундаментальный сдвиг в том, как мы создаём и развёртываем ИИ. В случае успеха это может открыть будущее, где мощный ИИ будет энергоэффективным, доступным и прозрачным.